Ur The Economist 10 juli 2023, översatt av InPress. ©2023 The Economist Newspaper Limited. Alla rättigheter förbehållna.

Vad handlar artikeln om?

Två grupper, så kallade superprognosmakare och AI-experter, fick i uppdrag att uppskatta sannolikheten för utrotning orsakad av AI eller kärnvapenkrig. Det visade sig att ämnesexperterna är mer pesimistiska än superprognosmakarna när de siar om en framtida AI-apokalyps och andra potentiella katastrofer.

Enrico Fermi, en av fysikerna som hade hjälpt till att bygga bomben, slog vad med sina vetenskapskollegor strax innan det första atombombstestet i New Mexicos öken 1945.

Skulle hettan från explosionen antända en kärnvapenutlöst eldstorm i atmosfären? Om så var fallet, skulle eldstormen bara förstöra New Mexico? Eller skulle hela världen förödas? Testet var inte riktigt så vårdslöst som Fermis okynniga vadslagning kan påskina. Hans Bethe, en annan fysiker, hade redan räknat ut att ett dylikt inferno nästan helt säkert var en omöjlighet.

Nuförtiden är det inte bara militära forskare som oroar sig för ”existentiella risker”. Det vill säga sådana risker som utgör ett hot mot mänskligheten som art, snarare än mot enskilda individer. Kärnvapenkrig, nukleär vinter, farsoter, oavsett om de är naturliga, som covid-19, eller konstruerade, asteroidkrascher och mycket annat har potential att utplåna nästan hela mänskligheten. Det senaste domesdagshotet är artificiell intelligens, AI. I maj signerade en grupp framstående forskare inom området ett öppet brev bestående av en enda mening: ”Att minska risken för utrotning på grund av AI bör vara en global prioritet, liksom andra samhällsrisker som pandemier och kärnvapenkrig”.

Två typer av katastrofer

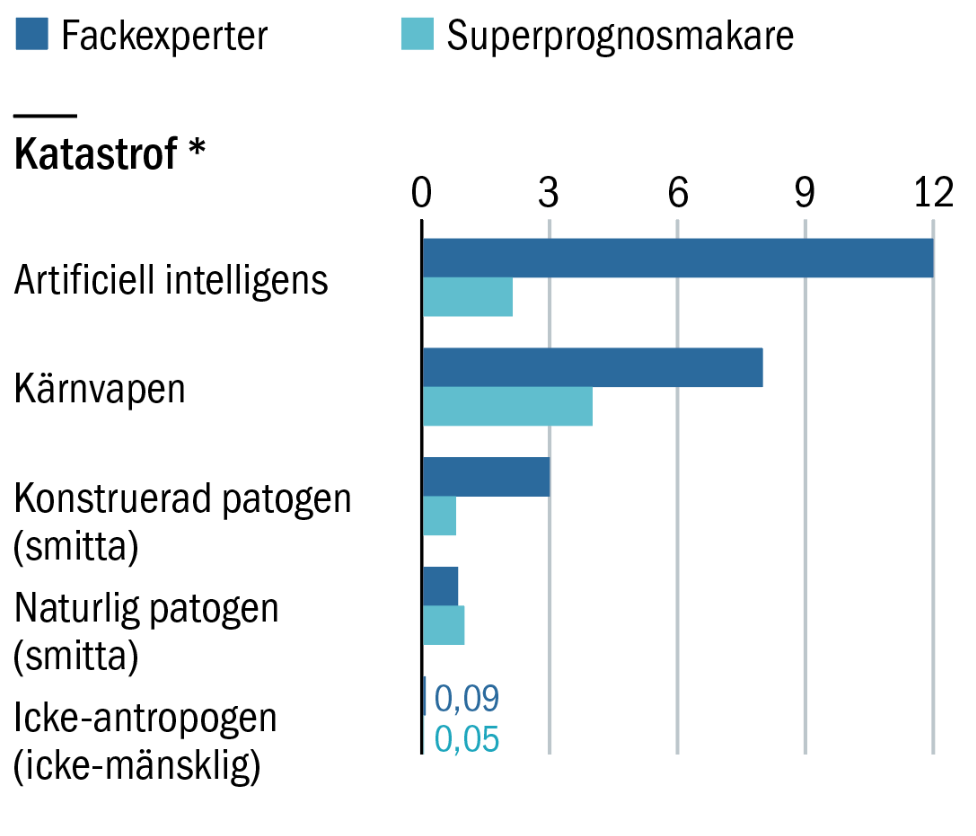

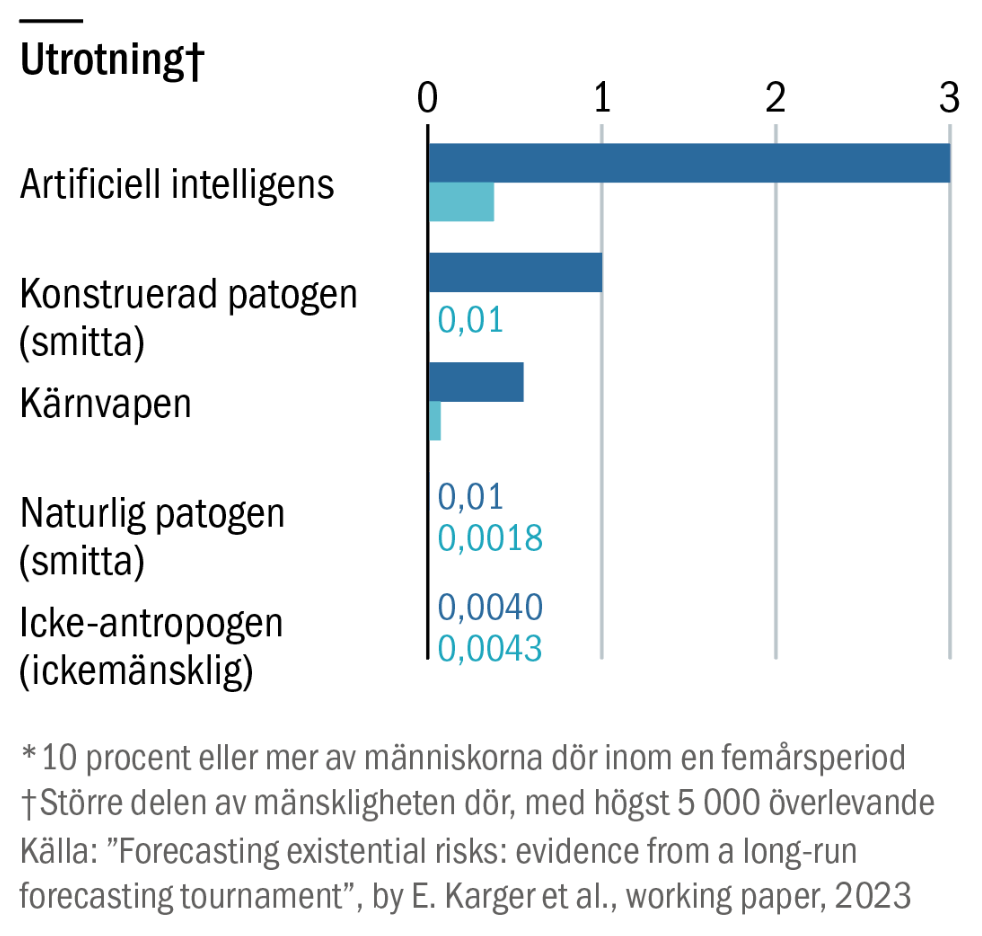

Men hur oroad är det egentligen rimligt att vara? Den 10 juli publicerade en grupp forskare, däribland Ezra Karger, ekonom vid Federal Reserve Bank of Chicago, och Philip Tetlock, statsvetare vid University of Pennsylvania, ett vetenskapligt så kallat ”working paper” med ambitionen att belysa frågan genom att systematiskt fråga ut två olika typer av experter. Å ena sidan fanns ämnesexperter på kärnvapenkrig, biologiska stridsmedel, AI och utplåning. På andra sidan fanns en grupp ”superprognosmakare”. Allmänna prognosmakare som historiskt hade lyckats göra korrekta förutsägelser om alla möjliga ämnen, från valresultat till krigsutbrott.

Forskarna rekryterade 89 superprognosmakare, 65 ämnesexperter och 15 experter på ”utrotningsrisk” mer generellt. De församlade siarna fick ta ställning till två olika typer av katastrofer. En ”katastrof” definierades som något som dödade blott 10 procent av människorna i världen, eller cirka 800 miljoner människor. Som jämförelse beräknas andra världskriget ha tagit livet av omkring 3 procent av världens dåvarande befolkning på 2 miljarder människor. Det vill säga omkring 60 miljoner. En ”utrotning” definierades som en händelse som utplånade alla förutom möjligen högst 5 000 lyckosamma, eller olycksaliga, själar.

Ämnesexperterna mer pessimistiska

De två grupperna ombads att uppskatta sannolikheten för allt från dödliga händelser som en utrotning orsakad av AI eller ett kärnvapenkrig, till mindre frågor som om oroväckande framsteg för AI-systemens förmågor skulle kunna inträffa och visa vägen mot en framtida katastrof.

Den mest slående slutsatsen av studien var att ämnesexperterna, som tenderar att dominera det offentliga samtalet om existentiella risker, verkar se dystrare på framtiden än superprognosmakarna. Ämnesexperterna räknade med en 20-procentig risk för en katastrof och en 6-procentig risk för utrotning till år 2100. Superprognosmakarna uppskattade sannolikheten för dessa händelser till 9 procent respektive 1 procent.

AI tar knappast över ditt jobb

Det kommer sannolikt att skapas nya jobb med hjälp av AI som är svåra att tänka sig i dag, men att den skulle driva på en extrem tillväxtökning är mer osäkert.

Denna uppdelning skymde några intressanta detaljer. Skillnaden mellan de två grupperna var störst när det gällde riskerna med AI. Medianvärdet för superprognosmakarna uppskattade risken för en katastrof orsakad av AI till 2,1 procent. Och vidare till 0,38 procent för en utrotning orsakad av AI i slutet av detta århundrade. AI-experterna däremot bedömde att risken för att de två händelserna skulle inträffa var 12 procent respektive 3 procent. När det gäller pandemier var superprognosmakarna mer pessimistiska än ämnesexperterna när det gällde riskerna för naturligt förekommande sjukdomsutbrott.

AI skulle kunna bli en ”kraftmultiplikator”

Det kanske mest intressanta resultatet var att även om grupperna var oeniga om exakt hur allvarlig risken var, ansåg båda att AI var det främsta orosmomentet. Detta oavsett om det handlade om katastrof eller utrotning (se diagram). En anledning till att AI ansågs som så betydelsefull var att den fungerar som en ”kraftmultiplikator” för andra risker, exempelvis kärnvapen, säger Dan Mayland, en superprognosmakare som deltog i studien.

Vid ett kärnvapenkrig eller ett asteroidnedslag skulle AI, exempelvis i form av beväpnade robotar, kunna tänkas döda människor direkt. Men AI skulle också kunna användas för att så att säga “slipa en annan bödels yxa”. Om människor till exempel använde AI för att kunna utforma mer potenta biologiska stridsmedel, skulle detta, om än indirekt, kunna vara ett viktigt bidrag till en eventuell katastrof.

Katastrofala risker beror inte bara på hur sofistikerad eller kraftfull en teknik blir, utan också på hur människan reagerar på den.

Men även om superprognosmakarna var pessimistiska i fråga om AI, så hade de också en relativt stor osäkerhet när det gällde AI. Världen har levt med kärnvapen i nästan 80 år nu. Att ett kärnvapenkrig ännu inte har inträffat är värdefull information som kan användas för att göra prognoser om huruvida ett kärnvapenkrig kan tänkas inträffa i framtiden. AI, åtminstone som vi definierar termen i dag, är betydligt nyare. De moderna, kraftfulla maskininlärningsmodellerna började komma under de första åren av 2010-talet. Området utvecklas fortfarande snabbt. Det innebär också att det finns betydligt färre historiska data att basera förutsägelser på.

Skillnad i modeller

Philip Tetlock har arbetat mycket med problemet att förutsäga framtiden. Det var han som först identifierade och myntade uttrycket ”superforecasters”. Det vill säga en grupp människor som verkade ovanligt bra på att förutsäga framtida utveckling inom alla möjliga områden. Sådana personer har vissa gemensamma drag. Exempelvis ett noggrant, numeriskt tänkande och en medvetenhet om att kognitiv partiskhet kan leda dem på villovägar. Trots bristen på specifik expertis har superprognosmakare visat sig kunna överträffa experter inom olika tekniska områden, från ekonomi till geopolitik.

Skillnaderna mellan experterna och prognosmakarna återspeglas delvis av skillnader mellan deras modeller av hur världen fungerar. Katastrofala risker beror inte bara på hur sofistikerad eller kraftfull en teknik blir, utan också på hur människan reagerar på den. Efter några skrämmande incidenter i början av kalla kriget började till exempel världens två största kärnvapenmakter, USA och Sovjetunionen, att samarbeta. Den heta linjen mellan Moskva och Washington, avtal om att inspektera varandras vapen och fördrag för att begränsa storleken på kärnvapenlagren bidrog till att minska risken för kärnvapenkrig.

Kan påverka varandra

Men superprognosmakare och AI-experter hade mycket olika syn på hur samhällen skulle kunna tänkas reagera på småskaliga skador orsakade av AI. Superprognosmakarna tenderade att tro att sådana skador skulle leda till noggrann genomlysning och reglering för att förhindra större problem senare. Fackexperter tenderade däremot att tro att affärsmässiga och geopolitiska incitament skulle kunna väga tyngre än säkerhetsfrågor, även efter att högst verkliga skador hade inträffat.

Ämnesexperterna och superprognosmakarna hade också olika åsikter om intelligensens begränsningar. Kjirste Morrell, en annan superprognosmakare som deltog i studien, uttrycker det enkelt: ”Det är helt enkelt inte så lätt att döda alla”. För att lyckas göra det, påpekar hon, krävs förmodligen ”en viss förmåga att interagera med den fysiska världen … och det behövs troligen en hel del framsteg inom robotteknik innan man når fram till det”.

Det grundläggande problemet med denna typ av förutsägelser är förstås att det till skillnad från händelser som inträffar upprepade gånger och får mindre omfattande konsekvenser, som aktiekursers rörelser eller valresultat, aldrig kommer att finnas någon möjlighet att veta vilket av lagen som kom närmast att uppskatta den verkliga risknivån. Men om superprognosmakarna är så bra på förutsägelser och fackexperterna har så mycket ämnesspecifik kunskap, skulle man i alla fall kunna tänka sig att de två grupperna kan påverka varandras övertygelser.

Kompletterande frågor

I studien försökte man uppmuntra till sådan ömsesidig övertalning genom gruppdiskussioner, ekonomiska incitament för bättre argument och liknande. Trots detta höll båda sidorna förvånande nog fast vid sina ståndpunkter. En AI-expert pekade på ”deliberation fatigue” som en tänkbar förklaring. Båda sidorna var helt enkelt utmattade av alla de prognoser som de redan hade ombetts göra.

Att ändra sig, eller ”justera antagandet”, som prognosmakarna skulle kalla det, kan bli enklare med nya bevis. Så Karger och Tetlock hoppas kunna samla in några sådana. De har bett deltagarna i studien att svara på ytterligare en uppsättning frågor om en rad ”indikatorer för tidig varning” – åtgärder som skulle kunna indikera om världen är på väg mot ett katastrofscenario.

Den mängd datorkraft som används i stora AI-övningar kan till exempel användas för att hålla koll på de allmänna framstegen inom området. Vilket öde som väntar fördragen om kärnvapenkontroll kan vara en annan faktor. Förhoppningen är att dessa mer kortsiktiga frågor, av vilka några kommer att vara lösta 2024 och 2030, ska ge en känsla för vilka förutsägelser man ska ta på större allvar – och därmed hur orolig man bör vara.

Denna text publicerades ursprungligen i det tryckta magasinet Världen Om, oktober 2023.

Läs fler artiklar från samma nummer här.

Så här jobbar Världen Om med kvalitetsjournalistik: Vi väljer ut artiklar. analyser, data och intervjuer från The Economist som täcker in geopolitik, vetenskap, livsstil, affärer och kultur. The Economist har funnits sedan 1843 för att "stärka kampen för intelligent upplysning i syfte att motverka okunskap som hindrar framsteg och utveckling."