Från papper och penna till världens snabbaste datorer att beräkna klimatförändringar.

Från School Brief 2020 publicerad i The Economist, översatt av InPress. ©2020 The Economist Newspaper Limited. Alla rättigheter förbehållna.

Om jorden inte hade några växthusgaser i sin atmosfär skulle den välbekanta skimrande gröna och blå planeten vara en karg klump av sten och is med genomsnittliga yttemperaturer runt -18 grader.

Planeten skulle inte få mindre solsken, vilket är den yttersta källan till jordklotets värme. Men när energin från solljuset återgick till infraröd strålning, vilket fysikens lagar kräver, skulle den försvinna ut i rymden utan att något hindrade den. Det är växthusgaserna som förhindrar att värmen försvinner så snabbt. De är genomskinliga för inkommande solljus och absorberar infraröd strålning, vilket värmer atmosfären, och därigenom även jordens yta. Resultatet är en genomsnittlig yttemperatur på +15 grader – tillräckligt varmt för att hålla haven öppna och biosfären prunkande och grön.

I slutet av 1800-talet fick upptäckten av istiderna forskarna att dra slutsatsen att klimatet kunde förändras globalt. Svante Arrhenius, en svensk kemist, undrade om det kunde bero på en försvagad växthuseffekt. Det var redan känt att koldioxid var en växthusgas. Eunice Foote, en amerikansk forskare, hade på 1850-talet upptäckt att den takt som en förseglad burk med luft värmdes upp med i solljuset berodde på andelen koldioxid i luften. Så Arrhenius – nyligen skild, något melankolisk till sinnes och i behov av ett projekt – påbörjade det mödosamma arbetet med att räkna ut effekterna på klimatet om man skulle halvera atmosfärens nivå av koldioxid.

För att göra det var han tvungen att tackla problem av en typ som både frustrerar och entusiasmerar de forskare som studerar jordsystemet: en feedbackloop genom vilken förändringen av en faktor påverkar en annan faktor, vilket i sin tur påverkar den första faktorn ännu mer.

Eftersom vatten förångas långsammare i kallare klimat, faller andelen vattenånga i atmosfären med temperaturen. Och vattenånga, liksom koldioxid, är en växthusgas. Att kyla ner atmosfären torkade ut den, vilket kylde ner atmosfären ytterligare. Många pennor och tusentals pappersark senare, drog Arrhenius slutsatsen att en halvering av koldioxidnivån skulle kyla ner planeten med fem grader.

Han noterade i förbifarten att samma sak skulle gälla i motsatt riktning: dubbla mängden koldioxid och du får fem graders uppvärmning. Industrins kolförbränning kunde alltså värma upp jorden, men bara – trodde han – mycket långsamt. Att koldioxidnivån skulle öka med en tredjedel på bara ett århundrade var inget han kunde föreställa sig.

Arrhenius drog slutsatsen att en halvering av koldioxidnivån skulle kyla ner planeten med fem grader.

Ungefär samtidigt som Arrhenius grubblade över klimatet, arbetade den norske vetenskapsmannen Vilhelm Bjerknes på fysiken om hur värme driver på vätskeflöden. Hans studenter applicerade dessa insikter på storskaliga flöden i atmosfären och haven, vilket lade grunden till 1900-talets väderprognoser. 1950 ingick en av Bjerknes studenters studenter, Ragnar Fjørtoft, i den grupp som först programmerade en dator att prognosticera väder genom att lösa sådana ekvationer. Datormodellerna, som är centrala för dagens klimatforskning, kombinerar Arrhenius nyfikenhet och Bjerknes tekniker.

Program som utvecklats från mjukvara för väderprognoser räknar ut hur nivåerna av koldioxid och andra växthusgaser sannolikt kommer att påverka världens flöden av värme, energi och vatten, och därigenom det framtida klimatet. För att göra det använder de datorer som är uppemot 25 000 miljarder gånger snabbare än den som användes 1950.

Dessa klimatmodeller behandlar inte atmosfären som en helhet. De delar in den i miljontals ”celler”. Förhållandena i var och en av dessa celler är beroende av förhållandena hos dess grannar över, under och vid sidorna, liksom cellens egen historiska utveckling. Tanken är att kalkylera hur förhållandena i varje cell förändras över tid. Till skillnad från en väderprognos som försöker förutsäga hur ett särskilt tillstånd hos atmosfären kommer att utvecklas under de närmaste dagarna, simulerar dessa modeller år, eller till och med århundraden, av väder för att utforska de medelvärden och sannolikhetsdistributioner som definierar klimatet – det som håller samman både normalfall och extremfall av framtida väder.

Dussintals forskargrupper vid meteorologiska institutioner och olika forskningsorganisationer runt hela världen kör sådana modeller. Alla använder olika kod för att fånga klimatets underliggande mekanismer och de studerar allt från framtida toppar i nederbördstoppar till stormspår och förändringar i säsongsmässighet.

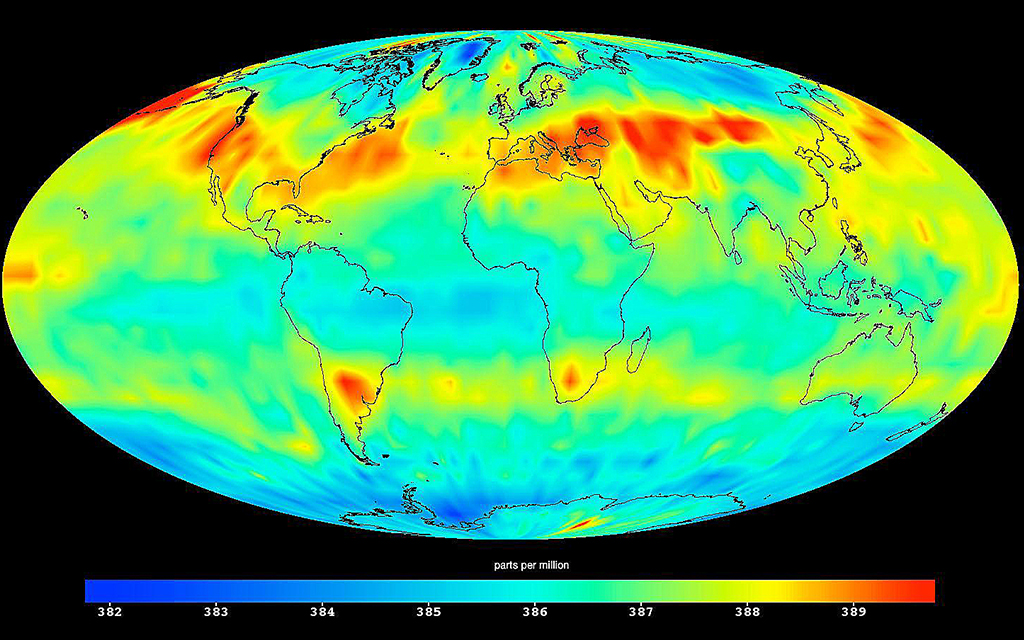

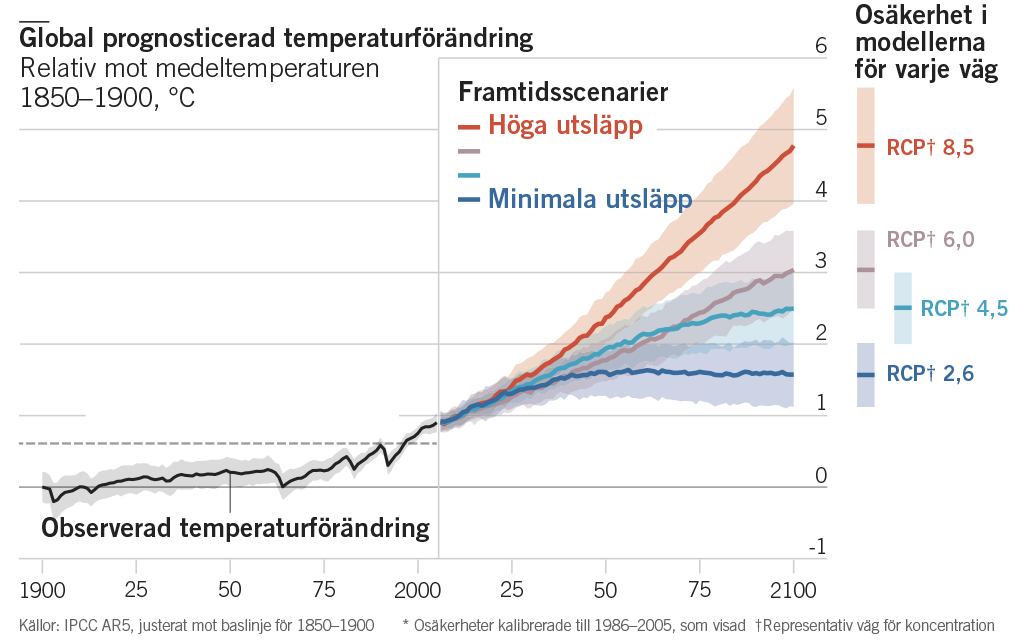

Sedan 1995 har Coupled Model Intercomparison Project, CMIP, sammanfört dessa grupper genom att tillhandahålla standardiserade uppgifter för modellexperiment och sedan jämföra resultaten. Till exempel visade de 56 olika modeller som analyserades i den femtedel av CMIP-projekten som avslutades under 2013, att en fördubbling av koldioxidnivåerna med tiden skulle åstadkomma en uppvärmning med mellan 1,5 och 4,5 grader. Osäkerheten kring vad modellerna visar när man studerar förhållanden i mindre skala är ännu större. Olika modeller kan ge mycket olika bilder av framtiden för regionala klimat.

De vitt skilda resultaten beror till stor del på att det inte finns två modeller som representerar klimatets mekanismer – och särskilt dess feedbacksystem – på exakt samma sätt. Vissa metoder kan man avfärda eftersom modellerna de producerar misslyckas med att uttrycka klimatets nuvarande uppförande eller hur det har uppfört sig historiskt (studier av istiderna med låga nivåer av koldioxid ger användbar kalibrering, något Arrhenius skulle ha gillat). Men bland de modeller som reproducerar tidigare och nuvarande klimat på ett rimligt bra sätt, finns det ingen bra metod att säga vilken av dessa representationer som är mest pålitlig. Skillnaderna mellan modellerna representerar en grundläggande nivå av osäkerhet, om man tar den nuvarande kunskapsnivån i beaktande.

Denna osäkerhet betyder dock inte att modellerna inte skulle ha något användbart att bidra med. Eftersom modellering har pågått så länge, är det nu möjligt att jämföra de förutsägelser som gjordes för flera årtionden sedan med hur saker och ting i slutändan blev.

En studie som publicerades förra året utvärderade systematiskt vad de modeller som publicerades mellan 1970-talet och 2007 hade sagt om hur klimatet skulle svara på stadiga koldioxidökningar. Den fann att händelseutvecklingen för 14 av 17 modeller låg inom felmarginalen för modellerna. Av de andra tre låg två i överkant och en i underkant. Att ta modellerna på allvar hade alltså varit en bra idé.

Så ändrar klimatet geopolitiken

Exklusivt för Världen Om analyserar Alasdair Ross hur klimatförändringar påverkar internationella relationer.

Den viktigaste källan till osäkerhet i modellerna är molnen. I takt med att växthusgaserna värmer upp atmosfären förändras dess fuktighet, liksom hur mycket den kyls ned ju högre upp man kommer. Dessa förändringar påverkar hur moln utvecklas; molnen i sin tur förändrar yttemperaturen. De flesta moln värmer upp jorden, vissa kyler ner den.

Problemet är att processerna som styr ett molns tjocklek, livslängd och andra egenskaper opererar i rätt liten skala. Det gör inte modellerna. Även om varje lager av atmosfären representeras av hundratusentals rutnätsceller, kan de ändå hamna hundratals kilometer åt fel håll – alldeles för mycket för att greppa de processer som är ansvariga för enskilda moln.

Inte all feedback stannar kvar inom atmosfären; en del fortsätter bortom den. Olika feedbackloopar binder ihop atmosfären med haven, som lagrar, flyttar och frigör värme på olika sätt och som bidrar en hel del till att påverka klimatet. På 1960-talet började modellerarna att försöka fånga dessa effekter genom att ”koppla” havsmodeller till modeller av atmosfären, så att vad de såg i atmosfären reflekterade förändringar i haven och vice versa.

Feedbackloopar som involverar landområden har också betydelse. Kallt väder innebär snö och snötäckt mark reflekterar bort mer solsken, särskilt om himlen är klar, vilket kyler ner saker och ting ännu mer. Biologi gör det hela än mer komplext. En tropisk regnskog pumpar in vattenånga i atmosfären betydligt mer effektivt än en savann gör. I varmare hav är det svårare för näringsämnen att nå ytan, vilket minskar planktonens förmåga att suga i sig koldioxid från atmosfären. Smältande permafrost producerar mängder av mikrobiell metan – en gas som absorberar infraröd strålning betydligt mer än koldioxid gör. Under årtionden har modellerare försökt bygga in allt mer av dessa ömsesidiga relationer i sina modeller, vilket har gjort dem avsevärt mycket mer komplexa.

Oturligt nog så minskar inte alltid osäkerheten med ökande komplexitet. En modell som exempelvis ignorerar istäckenas instabilitet – vilket de flesta gjorde tills alldeles nyligen – missar helt klart något viktigt. Men eftersom det finns olika sätt att införliva nya aspekter, kan två olika modeller som har uppdaterats för att ta med istäckesdynamik divergera mer efter denna ”förbättring” än de gjorde när de helt orealistiskt struntade i frågan. I CMIP6-processen, som håller på att närma sig sitt slut, visar preliminära resultat ett större spann av osäkerheter än man kunde se i CMIP5.

Den största källan till osäkerhet är dock inte vad som finns inuti modellerna, utan vad som finns utanför dem. Klimatförändring är ett problem eftersom mänsklig aktivitet adderar koldioxid, metan och andra växthusgaser till atmosfären i en oerhörd takt som är omöjlig för den fysik, kemi och biologi som har byggts in i modellerna att prognosticera.

För att uppskatta hur politiska förändringar skulle kunna påverka utsläpp används en annan familj av modeller – ”integrerade uppskattningsmodeller” (IAMS) som importerar förenklade resultat från klimatmodeller till modeller av ekonomin.

En av de saker som CMIP5 bad klimatmodellerarna att titta på, är hur klimatet skulle kunna utvecklas om utsläppen följer fyra standardiserade ”vägar” utvecklade från fyra olika IAMS på 2000-talet. Tre genererades utifrån IAMS som försökte simulera olika sorters klimatpolitik. Den fjärde, RCP8.5, som man ofta refererar till som ”business as usual”, genererades från en IAM med hög befolkningstillväxt, låg nivå av tekniska framsteg och storskalig användning av kol. Resultatet blev att utsläppen ökade spektakulärt, vilket gav en läskig, men inte särskilt användbar referenspunkt.

Osäkerheterna i vad modellerna förutspådde var lika slående som vanligt (se diagram). Men alla uppvisade en enighet om att bara ett vägval med de kraftfullaste klimatåtgärderna – betydligt mer drastiska än något som ses till eller utlovas i dag – möjligen skulle kunna ge världen en möjlighet att hålla nere temperaturökningen räknat sedan 1700-talet under två grader för 2000-talet, det mål som förordades i Parisavtalet 2015.

Denna text publicerades ursprungligen i det tryckta magasinet Världen Om, november 2020.

Läs fler artiklar från samma nummer här.

Så här jobbar Världen Om med kvalitetsjournalistik: Vi väljer ut artiklar. analyser, data och intervjuer från The Economist som täcker in geopolitik, vetenskap, livsstil, affärer och kultur. The Economist har funnits sedan 1843 för att "stärka kampen för intelligent upplysning i syfte att motverka okunskap som hindrar framsteg och utveckling."