Ur The Economist, 24 maj 2023, översatt av InPress. ©2023 The Economist Newspaper Limited. Alla rättigheter förbehållna.

Vad handlar artikeln om?

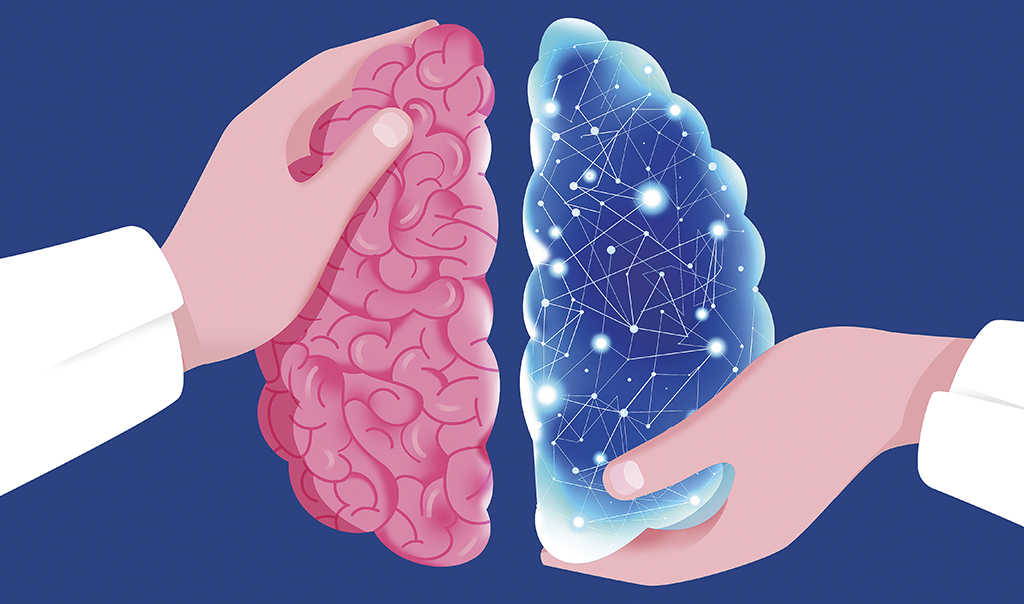

Artificiella neurala nätverk, ANN, är en programvarumodell som är löst inspirerat av neuroner i den mänskliga hjärnan. Den tycks ha anmärkningsvärda likheter med den mänskliga hjärnans funktionssätt. Om, eller när, biologiska hjärnor kan prata direkt med artificiella hjärnor, finns hopp om möjligheter till mer forskning och tester som annars vore både etiskt och praktiskt svåra att genomföra.

Den fantastiska utvecklingen inom artificiell intelligens under det senaste decenniet handlar främst om framsteg inom maskininlärning. Det innebär att datorer själva lär sig komplicerade uppgifter genom att bearbeta stora mängder data, i stället för att programmeras av människor. Den här metoden har gett en snabb utveckling inom datorseende, översättning av språk och, på senare tid, chattrobotars – som GPT-4:s – förmåga att föra människoliknande samtal.

Inlärningen görs med hjälp av programvarumodeller som kallas artificiella neurala nätverk, ANN. Standardbeskrivningen av ett neuralt nätverk är att det är löst inspirerat av nätverken av neuroner i den mänskliga hjärnan. Den beskrivningen följs ofta direkt av en friskrivning. Både datavetare och hjärnforskare är ivriga att påpeka att liknelsen är väldigt grovhuggen, att neuronnät bara är tecknade versioner av riktiga hjärnor, om ens det. De klarar inte att återge hela komplexiteten hos det riktiga, biologiska organet.

Visst stämmer det. Men en del hjärnforskare börjar inse att man faktiskt kan ta hjälp av serieteckningar. Den inre processen hos de bästa artificiella neuronnäten – de som är bäst på att imitera människans sätt att utföra uppgifter, som att identifiera föremål eller svara på skriftliga uppmaningar – tycks ha en del anmärkningsvärda likheter med den mänskliga hjärnans funktionssätt. Programmerarna hämtade inspiration från biologin och nu återgäldar de tjänsten när deras innovationer ger hjärnforskarna användbar information om den mänskliga hjärnan.

En avgörande studie som jämför hjärnor och artificiella neurala nät publicerades 2014 i Proceedings of the National Academy of Sciences. Hjärnforskaren Daniel Yamins vid Massachusetts Institute of Technology, MIT, och hans kollegor tränade ett artificiellt neuralt nät att känna igen motiv på foton – exempelvis en katt. Forskarna jämförde det som hände i det elektroniska nätverket med det som hände i den elektrodförsedda hjärnan hos apor av arten makaker, som hade fått samma uppgift.

Artificiella neuronnät byggs upp av ett stort antal artificiella neuroner som i likhet med sina naturliga motparter kan vara aktiverade eller inaktiverade, avfyrande eller tysta. De här neuronerna hänger ihop i sammankopplade nätverk i flera lager. Aktivitet i de nedre lagren kan påverka hur neuroner i de högre lagren aktiveras.

Daniel Yamins test handlar om bildigenkänning, som i fysiska hjärnor sker hierarkiskt. Ett lager neuroner identifierar enkla egenskaper som ljusa eller mörka områden. Ett högre lager organiserar dessa områden till kanter och ett ännu högre lager kombinerar kanterna till former. Denna process, med allt högre abstraktionsgrad, fortsätter tills hjärnan så småningom bestämmer sig för om den tittar på en katt, en hund eller en banan.

Bilder som har vissa gemensamma egenskaper stimulerar liknande kluster av neuroner att aktiveras. Om en viss uppsättning neuroner aktiveras när man tittar på en katt kommer sannolikt en annan, delvis överlappande, uppsättning att aktiveras när man tittar på en bild av en hund. De neuroner som svarar på båda bilderna fokuserar på egenskaper som förekommer på båda bilderna – det kan vara päls, fyra ben och svans.

När Daniel Yamins och hans kollegor jämförde det som hände inuti makakernas hjärnor med aktiviteten i artificiella hjärnor, upptäckte de slående likheter mellan hur aporna återgav bilderna och hur datorerna gjorde det. ”Den här studien fick avgörande betydelse”, säger Nancy Kanwisher, som också är professor vid MIT och har ägnat en stor del av sin karriär åt att studera människans synsystem. Nu använder hon artificiella neuronnät i en del av sin forskning. ”Det [artificiella] nätverket var inte alls utformat för att återspegla hjärnan. Det enda syftet var att lösa ett problem, men ändå ser vi denna oerhörda överensstämmelse.”

När en neuronnätsmodell utför en uppgift på ungefär samma sätt som en människa, vill hjärnforskarna jämföra modellen med den mänskliga hjärnan. De har hittat likheter mellan artificiella neurala nätverk som är tränade att känna igen tal och bearbeta språk, som programvara som omvandlar ljud till text, och människans hörselbark.

Mönstret återfinns också när det gäller skriftspråk. I en vetenskaplig rapport som publicerades 2021 jämfördes mänsklig hjärnaktivitet med flera olika kommersiella språkmodeller. Man kom fram till att det mest sofistikerade artificiella neurala nätet – som då var OpenAI:s GPT-2 – var det som mest liknade den mänskliga hjärnans aktivitet. Ju bättre modellerna blir på att lösa vissa uppgifter, desto mer kommer de att likna den mänskliga hjärnan när den gör samma sak.

Parallellerna mellan artificiella neuronnät och hjärnans nätverk kan också vara till hjälp när man behöver pröva antaganden om hjärnans funktionssätt. Man kan då använda sig av artificiella neuronnät. I en vetenskaplig rapport som publicerades 2022, författad av forskare vid Columbia University och MIT, konstaterade man att ett artificiellt neuronnät som tränats på att känna igen bilder producerade en grupp artificiella neuroner inriktade på att klassificera livsmedel. När rapporten publicerades fanns det, såvitt man visste, inga motsvarande områden i människans synsystem. Men året därpå meddelade forskare vid samma laboratorium att de hade upptäckt ett område i den mänskliga hjärnan där det faktiskt finns neuroner som aktiveras oftare när en individ tittar på bilder på mat.

Det kanske starkaste belägget för hypotesen att artificiella hjärnor kan bidra med viktig information om biologiska hjärnor är att programvara och den mänskliga hjärnan uppenbarligen kan samspela direkt med varandra.

Foto: Privat

Hjärnforskarna Nicholas Sexton och Bradley Love vid University College London var till en början ganska skeptiska till den påstådda likheten mellan naturliga och artificiella neuronnät. De menade att bara för att man observerade liknande aktivitetsmönster räckte inte det för att hävda att artificiella neuronnät och hjärnor löser problem på samma sätt. De menade att man skulle kunna ta fram bevis genom att undersöka om det var möjligt att mata in hjärnaktivitet i ett artificiellt neuralt nät.

2022 publicerade de en vetenskaplig artikel i Science Advances där de tittat på just detta. Forskarna matade ett artificiellt neuralt nätverk som tränats att känna igen bilder med data som registrerats av en MRI-maskin när den skannade mänskliga hjärnor. Tanken var att försöka låta det artificiella neurala nätet ”se” genom mänskliga ögon.

Och visst kunde det ”tjuvkopplade” artificiella neurala nätverket tolka data från alla hierarkiska lager i det biologiska synsystemet – även om det var bäst på data från de högre lagren, som redan till viss del hade bearbetats av den aktuella hjärnan. Om datormodellen fick se hjärnaktivitet från en människa som tittade på en bild av exempelvis en vinthund, så uppgav den att den tittade på en vinthund – och inte något annat motiv – i nästan 70 procent av fallen.

Att en artificiell hjärna är beredd att ta emot halvbearbetade data från en biologisk hjärna tyder på att de två systemen, på någon nivå, utför samma typ av kognitiva uppgifter. Den insikten kan visa sig vara användbar i gränssnitt mellan hjärna och dator – alltså verktyg vars syfte är att låta biologiska hjärnor prata direkt med maskiner.

Ett artificiellt neuralt nät som är anslutet till en kamera kan exempelvis användas för att mata in delvis bearbetad syninformation i hjärnan. Det kan vara till hjälp vid behandling av vissa typer av blindhet som beror på att hjärnans synsystem har skadats. Flera olika forskningsgrupper i USA och Europa testar redan idén i experiment på makakerapor.

Inte ens de största entusiasterna vill hävda att artificiella neurala nätverk är perfekta avbilder av den mänskliga hjärnan. Vissa neuronnät gör misstag som människor aldrig skulle göra – om man exempelvis visar ett artificiellt neuralt nät en bild av en katt med elefanthud, är det mest troligt att modellen identifierar den som en elefant. Men inga vetenskapliga modeller är perfekta. Frågan är dock om de är användbara. Ett av neurovetenskapens problem är att det är svårt att genomföra experiment, av både etiska och praktiska skäl. Att experimentera på artificiella neurala nät kan då vara ett praktiskt alternativ.

I alla händelser genererar det spännande resultat när man jämför biologi med datormodeller. I en vetenskaplig rapport som publicerades i maj, använde forskare vid University of Texas i Austin ett neuronnät för att övervaka hjärnsignaler från undersökningens deltagare i en MRI-skanner.

Enbart med hjälp av data från MRI-skannern kunde det artificiella neurala nätet ta fram en ungefärlig sammanfattning av en berättelse som deltagarna i försöket lyssnade på, en beskrivning av en film som de tittade på eller den ungefärliga innebörden i en mening de tänkte på. ”Under min magisterutbildning undrade jag om något sådant här skulle kunna bli verklighet”, säger Bradley Love. ”Jag trodde att det skulle dröja hundratals år innan vi skulle ha något som fungerar så här bra.”

Denna text publicerades ursprungligen i det tryckta magasinet Världen Om, oktober 2023.

Läs fler artiklar från samma nummer här.

Så här jobbar Världen Om med kvalitetsjournalistik: Vi väljer ut artiklar. analyser, data och intervjuer från The Economist som täcker in geopolitik, vetenskap, livsstil, affärer och kultur. The Economist har funnits sedan 1843 för att "stärka kampen för intelligent upplysning i syfte att motverka okunskap som hindrar framsteg och utveckling."